Künstliche Intelligenz transformiert heute ganze Branchen – durch die intelligente Verknüpfung von Mathematik, Logik und computergestützten Verfahren entstehen Systeme, die menschliche Intelligenz nicht nur nachahmen, sondern in vielen Bereichen übertreffen.

Maschinelles Lernen bildet das Herzstück dieser Revolution. Die Algorithmen und Techniken, die noch vor wenigen Jahrzehnten als visionäre Konzepte galten, profitieren heute von exponentiell gestiegener Rechenleistung und der Verfügbarkeit riesiger Datenmengen. Das Ergebnis: Neuronale Netze und moderne KI-Modelle, die in nahezu jeder wissenschaftlichen Disziplin bahnbrechende Lösungen ermöglichen.

Unser Ansatz

Wir schaffen den entscheidenden Unterschied durch die systematische Verbindung von Fachwissen und maschinellem Lernen. Während andere auf Black-Box-Lösungen setzen, entwickeln wir robuste und performante Modelle, die Sie verstehen und kontrollieren können.

Transparenz durch Erklärbarkeit: Da KI-Systeme oft schwer nachvollziehbar sind, statten wir Sie mit den notwendigen Werkzeugen aus, um jede Entscheidung Ihrer Modelle zu verstehen und zu bewerten.

Maßgeschneiderte Lösungen: Jedes Problem ist einzigartig – deshalb entwickeln wir für jeden Kunden individuelle Ansätze aus dem gesamten Spektrum des maschinellen Lernens.

Von der ersten Beratung bis zur finalen Implementierung: Wir machen KI für Ihr Unternehmen nutzbar, nachvollziehbar und erfolgreich.

Datenmanagement &

Datenanalyse

Dateninfrastruktur & Architektur: Robuste Daten brauchen robuste Systeme. Wir entwickeln skalierbare Data Pipelines für automatisierte ETL/ELT-Prozesse, implementieren Stream Processing für Echtzeitverarbeitung und konzipieren moderne Data Lakes & Data Warehouses. Ob Cloud Data Platforms auf AWS, Azure oder Google Cloud oder Microservices-Architekturen – wir schaffen die technische Grundlage für Ihre datengetriebene Zukunft.

Enterprise Integration: Ihre Daten leben nicht isoliert. Durch maßgeschneiderte API-Entwicklung stellen wir Daten über REST und GraphQL bereit, integrieren nahtlos Legacy-Systeme in moderne Datenarchitekturen und gewährleisten Real-time Data Serving mit minimaler Latenz. Bei komplexen Unternehmensstrukturen implementieren wir Data Mesh-Architekturen für dezentrale, domänenorientierte Datenverwaltung.

Strategische Datenaufbereitung: Hochwertige KI-Anwendungen beginnen mit strategischer Datenplanung. Durch intelligentes Design of Experiments berücksichtigen wir Ihr Domänenwissen bereits bei der Datenerhebung. Systematische Datenbereinigung und -vorverarbeitung eliminiert Fehler, während fortgeschrittene statistische Analysen versteckte Anomalien aufdecken. Unsere Feature-Engineering-Pipelines identifizieren die entscheidenden Eingangsgrößen und reduzieren Trainingsaufwand um bis zu 80% bei gleichzeitig verbesserter Modellgenauigkeit.

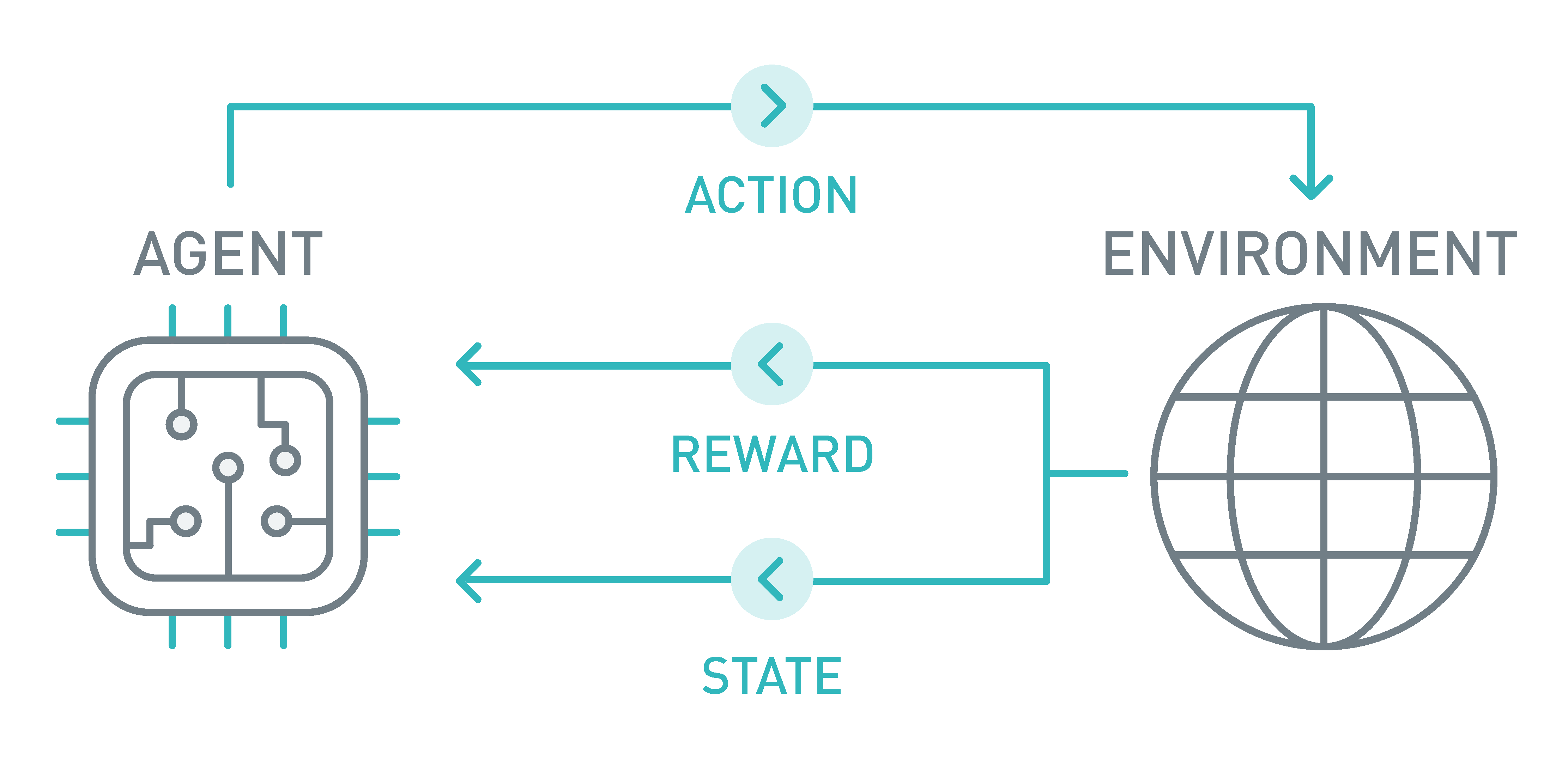

Reinforcement Learning & Approximate Dynamic Programming

Komplexe Systeme treffen täglich tausende sequenzielle Entscheidungen – von der Robotersteuerung bis zur Produktionsoptimierung. Während die klassische dynamische Programmierung theoretisch optimale Lösungen verspricht, scheitert sie in der Praxis an der schieren Komplexität realer Probleme.

Stochastische Systeme mit Markov-Prozessen: Bei Problemen mit zufälligen Elementen setzen wir Markowsche Entscheidungsprozesse (MDP) ein. Diese modellieren diskrete Regelungsprozesse mit probabilistischen Zustandsübergängen. Neuronale Netze approximieren Zustand und Regelungsstrategie, während Q-Learning und Temporal Difference Learning die optimalen Parameter ermitteln.

Modellfreies Reinforcement Learning: Ein lernfähiger Agent entwickelt durch Belohnungs-basiertes Lernen optimale Strategien, ohne vorherige Kenntnis des Systems. Ideal für Umgebungen, in denen die Systemdynamik unbekannt oder schwer modellierbar ist.

Deterministische Systeme mit modellprädiktiver Regelung: Für vorhersagbare Umgebungen nutzen wir modellprädiktive Regelung (MPC) – auch bekannt als modellbasiertes Finite-Horizon Reinforcement Learning. Dieser Ansatz berechnet vorausschauend die beste Aktionsfolge und passt sie kontinuierlich an neue Situationen an.

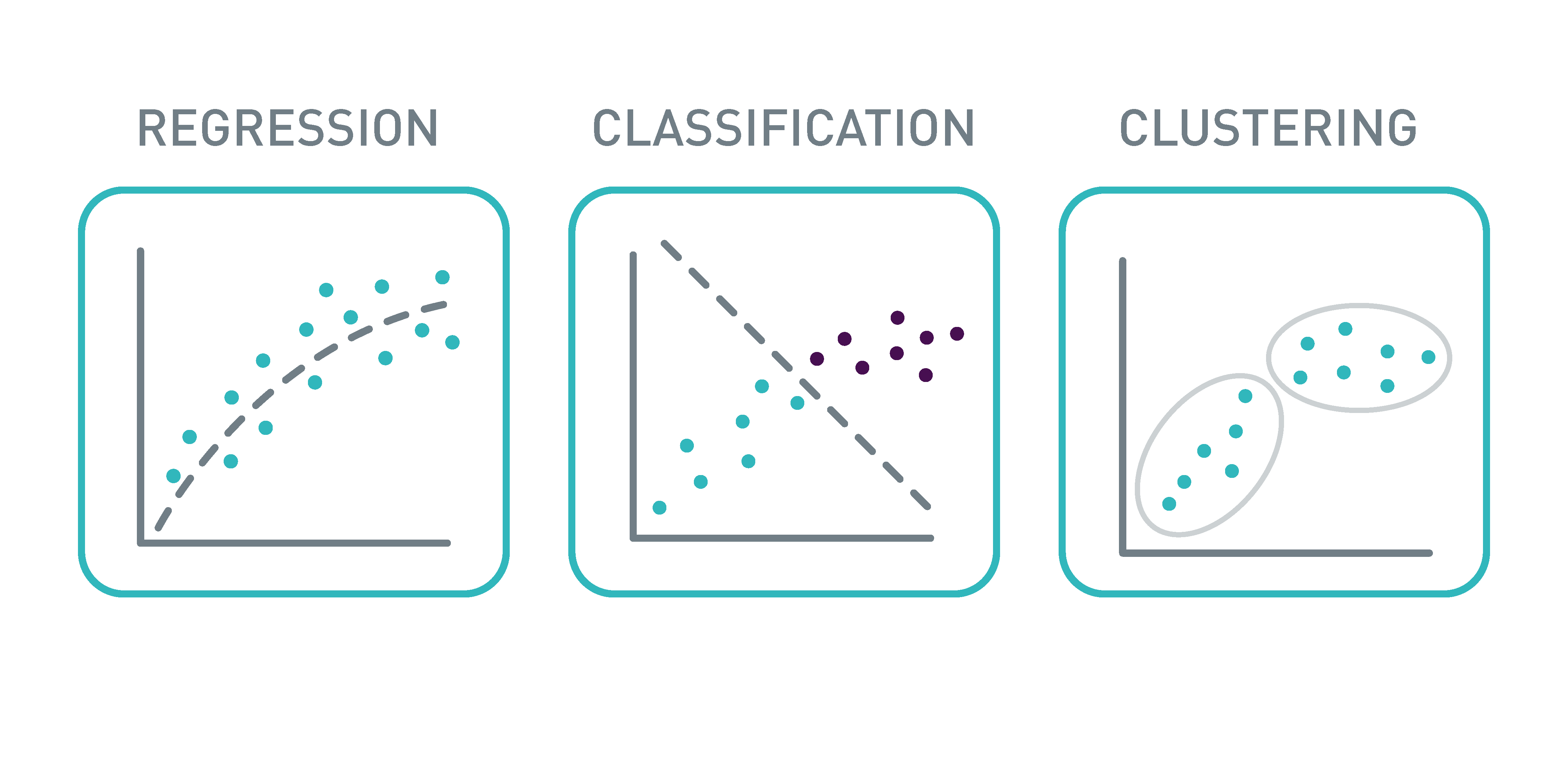

Maschinelles Lernen für Regression, Klassifikation & Clustering

Intelligente Systeme entstehen durch die richtige Kombination von Algorithmus und Anwendung. Wir entwickeln maßgeschneiderte datengetriebene Software-Lösungen, die genau zu Ihrem Problem passen – von der Modellauswahl bis zur produktiven Implementierung.

- Überwachtes Lernen: Wenn die "richtige Antwort" bekannt ist, nutzen wir diese Informationen optimal. Unser Spektrum reicht von symbolischen Methoden (genetische Programmierung) über Kernel-Verfahren (Gauß-Prozess-Regression, SVMs) bis hin zu Decision-Tree-Ensembles (Random Forest, Gradient Boosting) und neuronalen Netzen. Besonders tiefe neuronale Netze bewähren sich bei komplexen Aufgaben wie Bilderkennung, Zeitreihenprognosen und Online-Lernen.

- Halb- und selbstüberwachtes Lernen: Moderne Ansätze wie Transformers und Graph Neural Networks lernen aussagekräftige Datenrepräsentationen auch bei begrenzten Labels – ideal für Szenarien mit wenigen markierten Beispielen.

- Unüberwachtes Lernen: Verborgene Strukturen aufdecken ohne Vorgaben. Durch Clusteranalyse (K-Means, Support Vector Clustering) identifizieren wir unbekannte Gruppen, während Dimensionsreduktion (PCA, LDA) komplexe Daten verständlich macht.

Praktische Anwendungen: Diese Methoden ermöglichen es uns, konkrete Geschäftsprobleme zu lösen – von Predictive Maintenance über Ausreißer- und Anomalieerkennung bis hin zu dynamischer Regression für sich verändernde Systeme.

Modellauswahl &

Modellbewertung

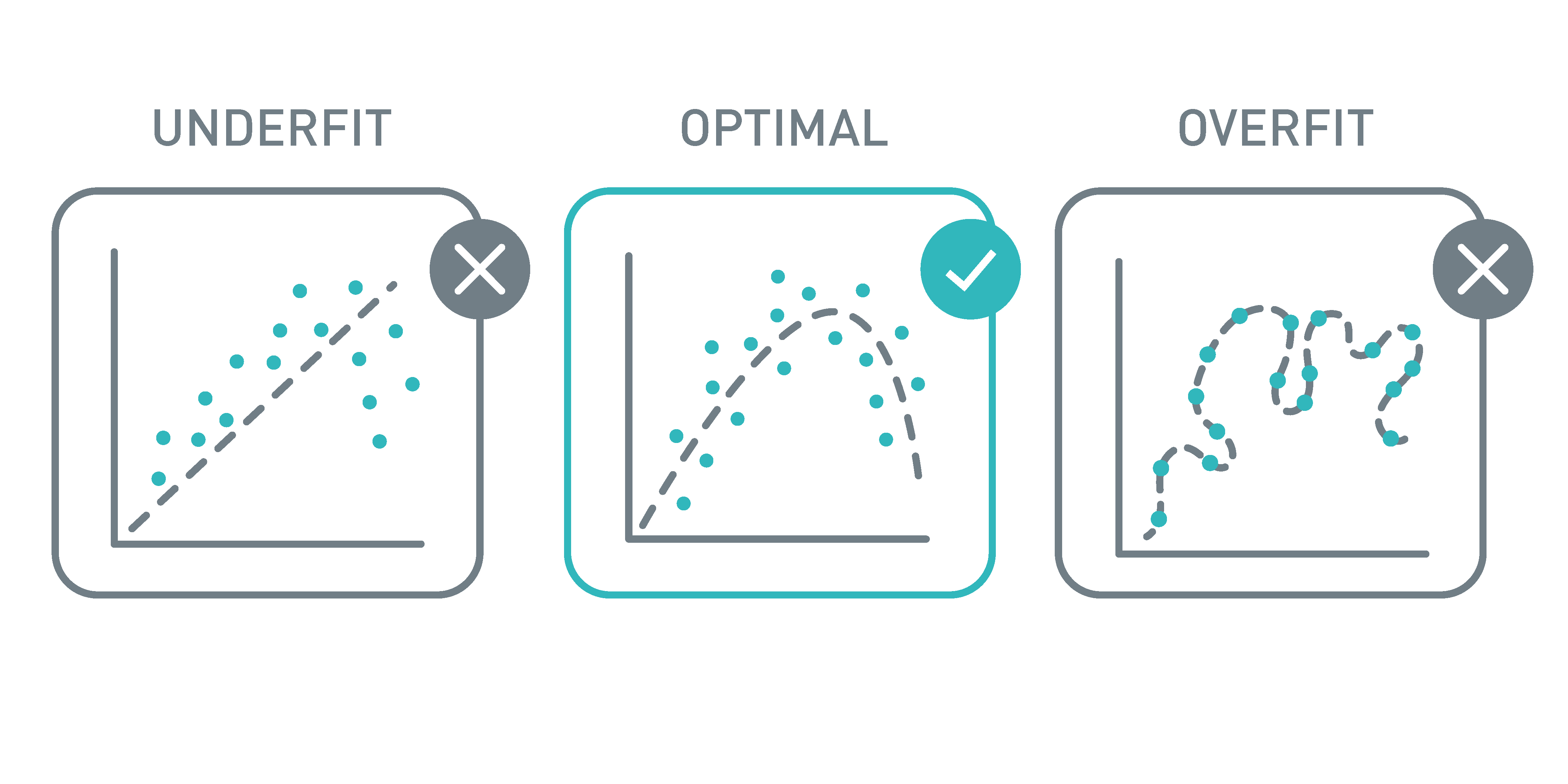

Ein trainiertes Modell ist nur so gut wie seine Performance auf echten, neuen Daten. Wahre Modellqualität zeigt sich erst im praktischen Einsatz – deshalb steht bei uns die Generalisierungsfähigkeit im Mittelpunkt jeder Entwicklung.

Systematische Modellauswahl: Wir vergleichen Kandidatenmodelle nicht nur auf Trainingsdaten, sondern bewerten sie nach individuell definierten Kriterien auf unabhängigen Testdatensätzen. Nur Modelle, die auch auf ungesehenen Daten überzeugen, kommen in die engere Auswahl.

Robustheit durch intelligente Algorithmen: Das Bias-Varianz-Dilemma lösen wir bereits während des Trainings durch bewährte Techniken wie Bootstrapping, Boosting und Regularisierungsmethoden (Ridge, Lasso, Dropout). Diese Ansätze verbessern nicht nur die Prädiktionsgenauigkeit, sondern auch die Interpretierbarkeit der finalen Modelle.

Transparenz und Erklärbarkeit: Black-Box-Modelle schaffen kein Vertrauen. Durch moderne Explainable AI-Methoden wie Shapley Additive Explainers (SHAP) machen wir jede Modellentscheidung nachvollziehbar. Das schafft nicht nur Transparenz, sondern deckt oft neue Erkenntnisse über die zugrundeliegenden Prozesse auf.

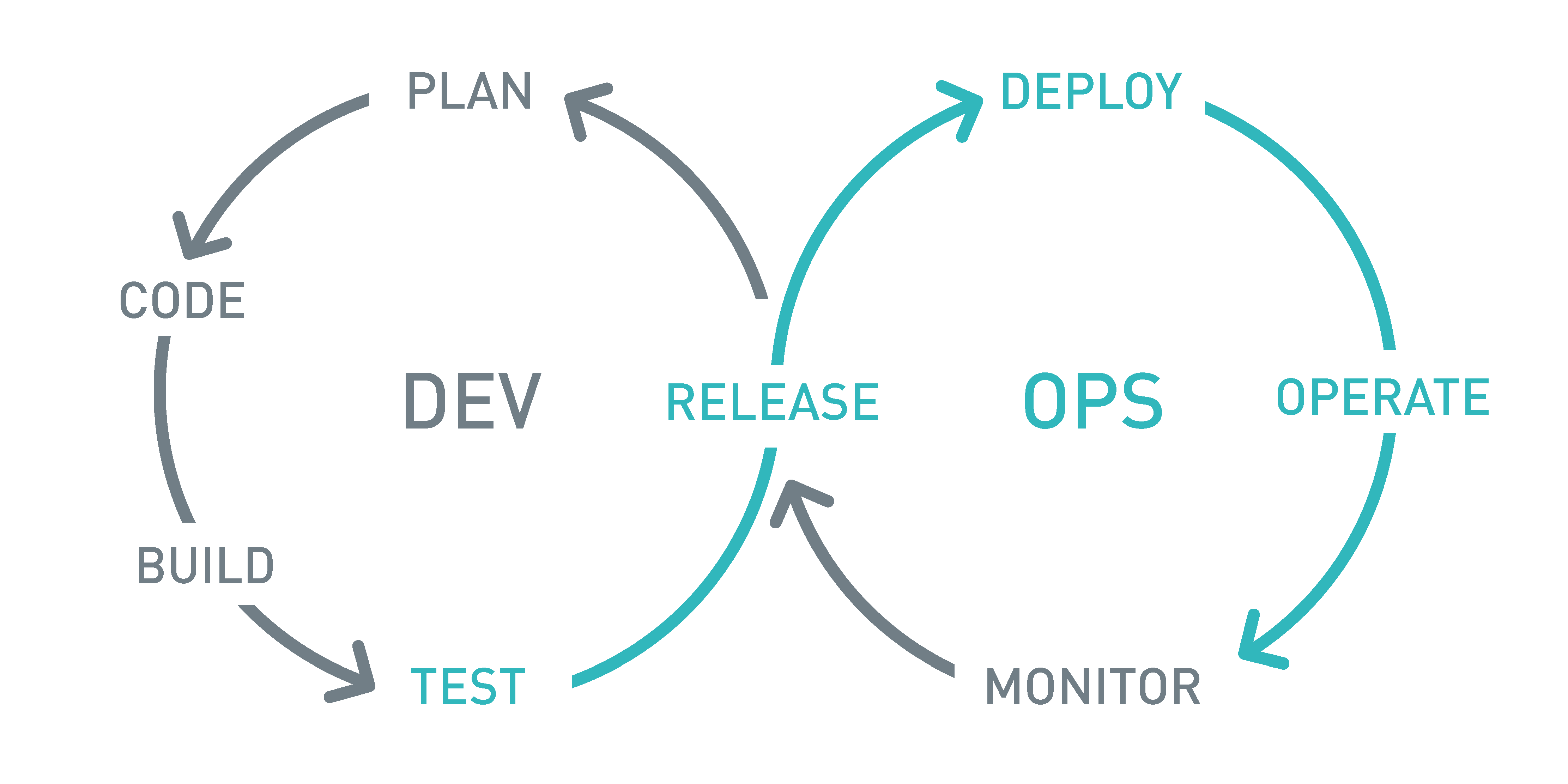

Auslieferung & Einsatz fertiger Modelle

Von der Entwicklung zum produktiven Einsatz: Hier entscheidet sich, ob ein KI-Projekt wirklich erfolgreich wird. Wir sorgen dafür, dass Ihre Modelle nicht nur funktionieren, sondern optimal performen und langfristig wartbar bleiben.

Performance-Optimierung vor Deployment: Bevor ein Modell in die Produktion geht, schöpfen wir sein volles Potenzial aus. Transfer Learning nutzt bewährtes Wissen für neue, komplexere Aufgaben und steigert die Genauigkeit bei reduziertem Trainingsaufwand. Durch gezieltes Fine-Tuning mit niedrigen Lernraten erreichen wir die optimale Balance zwischen Stabilität und Performance.

Plattformübergreifende Kompatibilität: Verschiedene ML-Frameworks bedeuten verschiedene Architekturen. Unsere ONNX-Integration überführt Modelle in ein universelles Standardformat, das in jeder Programmiersprache und Umgebung funktioniert. Gleichzeitig optimiert ONNX die Prädiktionsgeschwindigkeit für Echtzeit-Anwendungen.

Intelligente Wartung und Updates: KI-Modelle sind lebende Systeme. Wenn neue Datenquellen, Klassen oder Concept Drift auftreten, implementieren wir automatisierte Retraining-Pipelines, die Ihre Modelle kontinuierlich aktuell halten. Das System lernt selbstständig weiter, ohne manuelle Eingriffe zu erfordern.

Das Ergebnis: Produktionsreife KI-Systeme, die sich nahtlos in Ihre bestehende IT-Landschaft integrieren, optimal performen und sich selbstständig an veränderte Bedingungen anpassen – für nachhaltigen ROI Ihrer KI-Investition.

Verknüpfte Lösungen

Beteiligte Forschungsgruppen