Assistive und Autonome Systeme (Fahrzeuge, Arbeitsmaschinen, Fluggeräte) benötigen zur zuverlässigen und sicheren Durchführung ihrer Aufgaben eine Reihe von grundlegenden Technologiekomponenten. Eine davon ist die robuste Umgebungswahrnehmung, die für alle Arten von Fahr- und Arbeitsszenarien unerlässlich ist, um befahrbare Bereiche zu erkennen und Kollisionen zu vermeiden. Hierfür bedarf es multimodaler Sensoren sowie Datenanalysemethoden wie Bildverarbeitung oder Machine Learning. Eine weitere ist die Standortbestimmung auf einer gegebenen Karte - basierend auf diversen Positionsdaten von Satelliten oder einer visuellen Lokalisierung. Jedoch sind Kartendaten oft nicht verfügbar oder unvollständig.

Aus diesem Grund erforschen und entwickeln wir seit mehreren Jahren die Sensorik und Methoden zur sicheren Umgebungserfassung, Lokalisierung und Kartierung für Assistenzsysteme und autonome Systeme in diversen Anwendungsbereichen.

Umgebungswahrnehmung

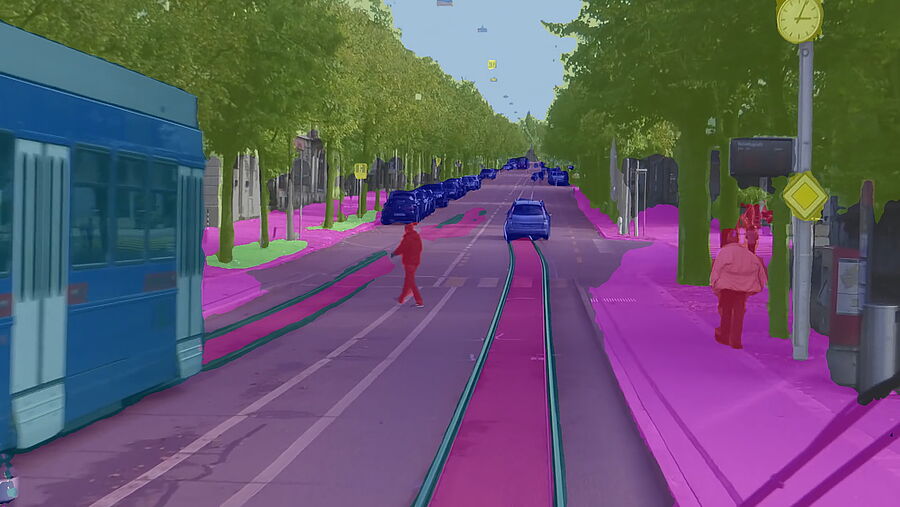

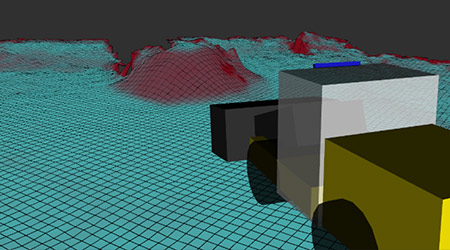

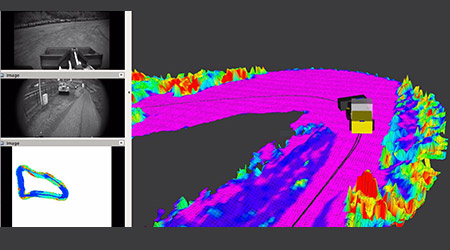

Die Wahrnehmung der Umgebung basiert auf multimodalen Sensordaten von Kameras (RGB, IR, multispektral), Laserscannern, Radar, Time-of-Flight oder Ultraschallsensoren. Wir erforschen und entwickeln Methoden zur Datenverarbeitung, Analyse und Fusion, um daraus geeignete Informationen für Aufgaben wie Kollisionsvermeidung, Objektklassifizierung, Lokalisierung/Orientierung und Tracking sowie Szenenverständnis auf einer höheren Abstraktionsebene abzuleiten. Die Lokalisierung, Navigation und die richtige Handhabung von Objekten durch Maschinen (z. B. Kran oder Gabelstapler) erfordert nicht nur eine 2D-, sondern auch eine 3D-Modellierung der Umgebung auf der Grundlage von Punktwolken, die von Laserscannern, Stereokamerasystemen oder Radarsensoren geliefert werden. Raue Umgebungsbedingungen im Freien – starker Regen, Nebel, Schmutz oder Staub stellen eine erhebliche Herausforderung dar. Lichtbasierte Sensoren geraten sin in solchen Fällen an ihre Grenzen. Daher werden alternative physikalische Modalitäten wie Radar benötigt, um wesentliche Wahrnehmungsfunktionen aufrechterhalten zu können. Jede Sensormodalität hat ihre Stärken und Schwächen; und um die Schwächen auszugleichen, ist es notwendig Daten zu fusionieren.

Lokalisierung & Mapping

Das Wissen um die genaue Position und Orientierung in einer Referenzkarte der Umgebung ist eine unerlässliche Voraussetzung sowohl für viele Assistenzsysteme als auch für einen zuverlässigen Betrieb automatisierter Fahrzeuge oder Maschinen. Informationen dazu liefern in vielen Fällen Satellitennavigationssysteme (GNSS), deren Genauigkeit durch Korrektursignale von bodengestützten Referenzstationen erhöht werden kann. Aufgrund von Verdeckungen von Satelliten, insbesondere in Stadtgebieten, Bergregionen oder auf Firmengeländen, ist GNSS allein nicht zuverlässig und muss durch alternative Verfahren wie SLAM (simultaneous localization and mapping) oder lokale funkbasierte Systeme ergänzt oder ersetzt werden.

Spezifische Navigations- und Arbeitsszenarien von Fahrzeugen und Maschinen, z.B. wenn diese Objekte handhaben sollen, erfordern detaillierte Karten mit einer semantischen Segmentierung der Inhalte sowie einer dynamischen Aktualisierung, um die Szenarien korrekt zu erfassen. Die Kartenerstellung und -anpassung kann durch Sensoren wie Kameras, Laserscanner oder bildgebende Radarsensoren erfolgen, die an Maschinen, Fahrzeugen oder auch Infrastruktureinrichtungen des Geländes angebracht sind.

Wir erforschen und entwickeln Methoden zur Lokalisierung und Kartierung basierend auf Kamera-, Laser- oder Radardaten (z.B. SLAM) und evaluieren moderne Systeme (z.B. GNSS RTK Systeme).

Maschine & Deep Learning

Für eine robuste Umgebungswahrnehmung ist neben der „klassischen“ Sensordatenanalyse wie Computer Vision, Maschinelles Lernen unerlässlich.

In den letzten Jahren haben wir daher Methoden der Objektklassifizierung, der semantischen Umgebungssegmentierung, des Trackings und der 3D-Posenschätzung erforscht, Netze trainiert und die notwendige Recheninfrastruktur aufgebaut.

Auch für die Handhabung verschiedener Arten von Objekten sowie für (teil-) automatisierte Maschinen, die durch die Interaktion mit Menschen lernen, untersuchen wir Methoden der künstlichen Intelligenz. Für die dreidimensionale Rekonstruktion der Umgebung, Bewegungsplanung und für Navigationsaufgaben erforschen und nutzen wir Machine-Learning-Ansätze wie Self-Supervised und Reinforcement Learning. Darüber hinaus entwickeln wir Werkzeuge, um effizient Daten zu annotieren und Netzwerke bei großen Sensordatensätze (z.B. Bilddatenbanken) zu trainieren. Inzwischen können wir umfangreiche Datensätze für Luftfahrt-, Transport-, Bau- und Landwirtschaftsszenarien zurrückgreifen.

Beispiele für die Nutzung der von uns entwickelten und hier beschriebenen Technologiekomponenten sind:

- Assistenzsysteme für Straßenbahnen

- Automatisierte Lade- und Transportvorgänge in der Logistik (Gabelstapler, Kräne)

- Assistenzsysteme für Baumaschinen

- Überwachung des Luftraums und Assistenzsysteme für unbemannte Fluggeräte

- Automatisierte Unkrautbeseitigung in der biologischen Landwirtschaft

Verknüpfte Lösungen

Beteiligte Forschungsgruppen

Ausgewählte Projekte

- Autility / Smarter

- Hopper

- Arctis / HARV-EST

- ODAS Straßenbahnassistenzsystem

- Tower

- Elena