Am AIT Austrian Institute of Technology wird ein Software-System entwickelt, das Hinweise auf gefälschte Texte, Bilder, Audiosignale und Videos bündelt und daraus eine gesamthafte Einschätzung des Wahrheitsgehaltes einer Nachricht erstellt.

Die Verbreitung von Desinformation ist eine ernste Bedrohung: Fake News beeinflussen Entscheidungen, führen zu Verunsicherung, zum Aufbau von Unzufriedenheit in der Öffentlichkeit und zur Destabilisierung von Gesellschaft und Demokratie. In Krisenzeiten wie der aktuellen Covid-19-Pandemie hat Desinformation einen neuen negativen Gipfelpunkt erreicht, sowohl staatliche Organisationen und Medienunternehmen als auch jeder einzelne Bürger, jede einzelne Bürgerin stehen vor großen Herausforderungen, für die es derzeit kaum geeigneten Antworten oder wirksame Gegenmaßnahmen gibt.

Die Forschung macht indes Fortschritte, um die unkontrollierte Verbreitung von Desinformationen unter Einhaltung sozialer, kultureller und rechtlicher Normen zu bekämpfen. Mit neuen, auf Künstlicher Intelligenz (KI) basierenden Methoden sowie mit der Zusammenführung von Informationen aus unterschiedlichen Quellen soll es möglich werden, den Wahrheitsgehalt von Nachrichten künftig automatisch zu überprüfen. Der Weg dorthin ist indes noch steinig, in vielen Bereich müssen noch hohe Hürden überwunden werden.

Videos aus dem Computer

Ein zur Zeit heiß diskutierter Bereich sind „Deep Fakes“, also manipulierte Videos, in denen die handelnden Personen ausgetauscht wurden bzw. ihnen Aussagen in den Mund gelegt werden, die sie niemals gesagt haben. Die Grundlage für gefälschte Bilder sind sogenannte „Generative Adversorial Networks“ (GAN). Dabei handelt es sich um zwei miteinander gekoppelte Deep-Learning-Systeme: Ein „Generator“ erzeugt künstlich Bilder, ein „Diskriminator“ versucht, diese als echt oder falsch einzustufen. In vielen Runden lernt der Generator, bessere Bilder zu fälschen, und der Diskriminator, diese korrekt zu klassifizieren. „Die beiden Künstlichen Intelligenzen trainieren einander gegenseitig“, erläutert Ross King, Leiter der Competence Unit Data Science & Artificial Intelligence am AIT.

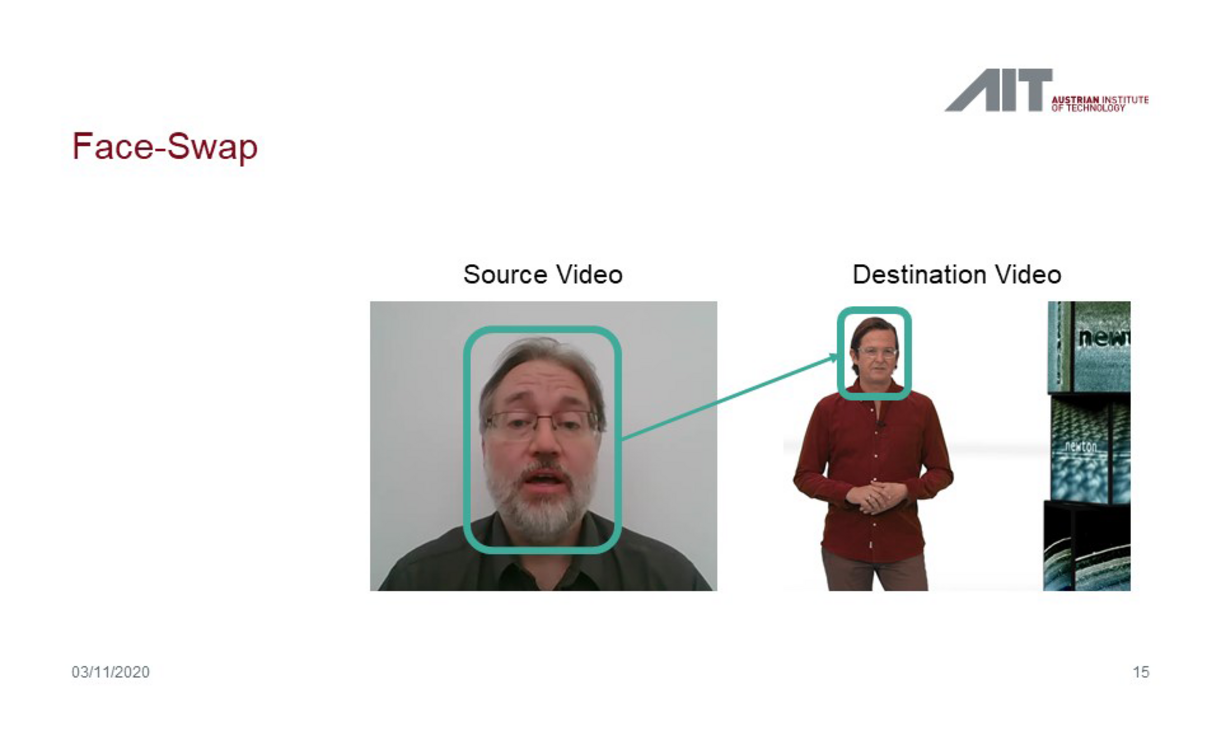

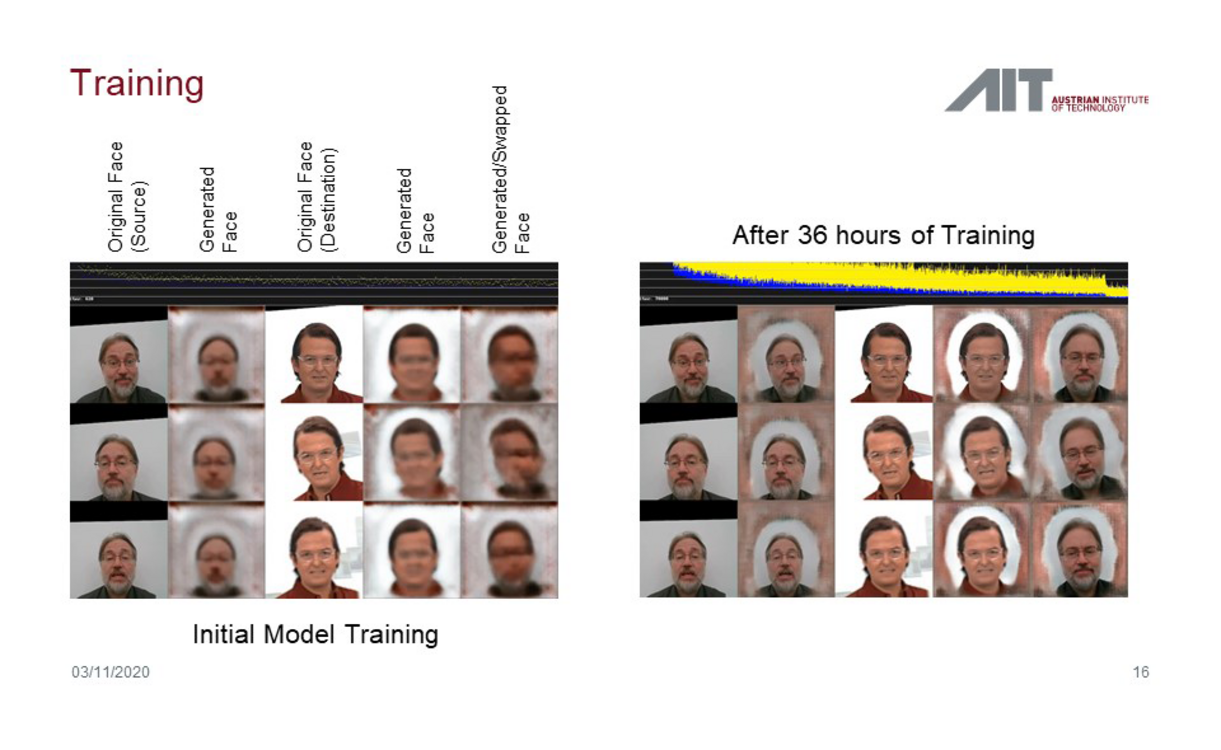

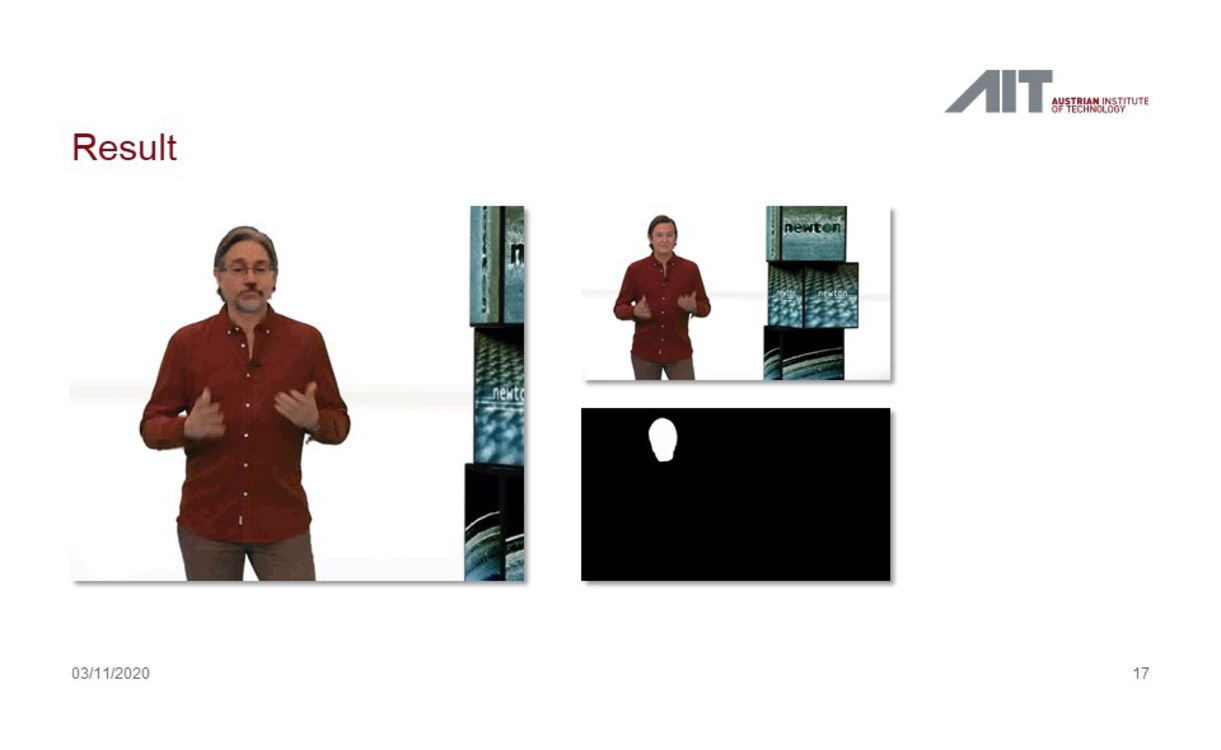

Ähnliches lässt sich auch auf Videos anwenden. Beim „Face Swapping“-Verfahren lernt ein KI-System, das Gesicht von Person A zu rekonstruieren. Ein weiteres System analysiert Bewegungsmuster von Person B. Im nächsten Schritt wird das Gesicht von A mit dem Bewegungsstil von B verknüpft („Style Transfer“), wodurch täuschend echte Videos von Situationen entstehen, die es in der Realität nie gab. „Die Software dafür ist gratis im Netz erhältlich, es gibt sogar gute Anleitungen, die man nur Schritt für Schritt ausführen muss“, berichtet Alexander Schindler, Fake-News-Experte und Data Scientist am AIT.

Allerdings – und das ist die gute Nachricht dabei – sei dieses Verfahren für hochqualitative Fakes sehr aufwendig und daher noch nicht massentauglich. Die berühmt gewordenen gefälschten Videos von Spitzenpolitikern seien das Ergebnis von professionellen Produktionen durch hochspezialisierte Teams, erklärt der Forscher.

Virtuelle Gesichter blinzeln nicht

Eine der Schwierigkeiten dabei ist, dass es noch keine Möglichkeiten gibt, einer bestimmten Stimme einen beliebigen Text in den Mund zu legen (Details siehe unten). Bei den bekannten Deep-Fake-Videos wurden Stimmenimitatoren engagiert, die einen exakt geplanten Text einsprechen, der zur Gestik und zur Körperhaltung der Person passt, deren Gesicht ersetzt wird.

Ein weiteres Problem entsteht, wenn es für die Computer-generierten Gesichter nicht genügend Bilder aus allen Lebenslagen gibt, anhand denen die KI trainiert wird. Das betrifft vor allem „Avatar-Methoden“, bei denen das Ursprungsgesicht durch Gesichtsbewegungen eines zweiten Darstellers manipuliert werden. So gibt es für die meisten Personen des öffentlichen Interesses kaum Bilder, auf denen sie die Augen geschlossen haben. Die Folge: Die Gesichter in Deep-Fake-Videos blinzeln nicht – und das lässt sich sehr einfach detektieren. Wenn es nur wenige Trainingsbilder für die KI gibt, wird überdies die Hautstruktur zu glatt und gummiartig dargestellt, es kommt zu unnatürlichen Verzerrungen. Auch dies kann relativ einfach nachgewiesen werden.

Zu den herkömmlichen Methoden der Bildforensik (etwa die Analyse von Metadaten, von Schatten im Verhältnis zu Lichtquellen oder des Bildrauschens) kommen durch KI-Methoden nun weitere Verfahren dazu. „Die neuen Methoden sind adaptiver und können viel besser erklären, wo sie Manipulationen entdeckt haben und welcher Art die Manipulationen sind“, so Schindler. Überdies könne man Rückschlüsse auf die Ursprungsbilder ziehen. „Bei generierten Inhalten kämpft nun KI gegen KI“, fasst der Experte zusammen.

So wird ein Deep Fake mit der Methode des „Face Swapping“ (Gesichts-Tausch) erstellt: Im ersten Schritt wird der Computer darauf trainiert, das Gesicht einer Person zu rekonstruieren. Dasselbe geschieht mit dem Körper einer zweiten Person. Im letzten Schritt wird schließlich das Gesicht der ersten Person in das Video der zweiten Person hineinkopiert. Hier wurde als Beispiel – erstellt für die ORF-Dokumentation „Newton“ – das Gesicht des Moderators gegen das des AIT-Forschers Ross King ausgetauscht.

So wird ein Deep Fake mit der Methode des „Face Swapping“ (Gesichts-Tausch) erstellt: Im ersten Schritt wird der Computer darauf trainiert, das Gesicht einer Person zu rekonstruieren. Dasselbe geschieht mit dem Körper einer zweiten Person. Im letzten Schritt wird schließlich das Gesicht der ersten Person in das Video der zweiten Person hineinkopiert. Hier wurde als Beispiel – erstellt für die ORF-Dokumentation „Newton“ – das Gesicht des Moderators gegen das des AIT-Forschers Ross King ausgetauscht.

So wird ein Deep Fake mit der Methode des „Face Swapping“ (Gesichts-Tausch) erstellt: Im ersten Schritt wird der Computer darauf trainiert, das Gesicht einer Person zu rekonstruieren. Dasselbe geschieht mit dem Körper einer zweiten Person. Im letzten Schritt wird schließlich das Gesicht der ersten Person in das Video der zweiten Person hineinkopiert. Hier wurde als Beispiel – erstellt für die ORF-Dokumentation „Newton“ – das Gesicht des Moderators gegen das des AIT-Forschers Ross King ausgetauscht.

Stimmen lassen sich kaum fälschen

Wie erwähnt, ist man bei Audio-Daten noch nicht so weit wie bei Bildern. „Aktuell ist es noch sehr schwierig, wirklich natürliche Stimmen künstlich zu generieren“, sagt Schindler. Der Hauptgrund dafür ist, dass wir beim Hören wesentlich sensibler sind als beim Sehen. „Wir sind es mittlerweile gewohnt, dass Bilder verrauscht sind oder eine niedrige Auflösung haben und verpixelt sind. Bei der Sprache sind wir da viel skeptischer.“ Dazu kommt, dass sich Rauschen bei Audio-Signalen anders äußert: Die Stimme klingt metallisch, man hört Phasenverschiebungen und ähnliches.

Daher gibt es bis heute keine befriedigenden Algorithmen etwa für einen Stiltransfer von Audio-Dateien (womit Sprachrhythmik, Sprachmelodie oder Stimmlage an eine Zielperson angepasst werden könnten). „In diesem Bereich haben wir gegenüber Produzenten vom Fake-Nachrichten noch einen zeitlichen Vorsprung“, so Schindler. Allerdings erwartet er auch in diesem Feld in den nächsten Jahren einige Fortschritte. Trainingsdaten für KI-Systeme dafür gibt es jedenfalls: Audiobücher, in denen für jedes geschrieben Wort auch eine gesprochene Variante vorliegt.

Gefälschte Audiosignale kann man – derzeit – gut mit herkömmlichen Methoden der Audioforensik erkennen. Das reicht von der Analyse der Netzwerkfrequenz des Stroms, an dem ein Aufnahmegerät hängt, über die Klassifikation des Mikrophons bis hin zur Analyse der Phasenlage der Schallschwingungen (wodurch man etwa Schnitte nachweisen kann). In Zukunft werden auch im Audiobereich KI-Systeme dabei helfen, Fakes zu erkennen.

Automatisches Fact-Checking noch in den Kinderschuhen

Sehr viel schwieriger ist das Finden von Fake News in Texten. „Hier wird so viel Inhalt vermittelt, der Allgemeinwissen erfordert, dass die Detektion von Falschinformation für den Computer sehr schwierig ist“, so Schindler. Am besten funktioniert daher immer noch das manuelle Fact-Checking. Aber dies könne man nur anlassbezogen machen – „man kann damit nicht Millionen von Internetseiten auf Falschmeldungen prüfen“.

Automatisches Fact-Checking steckt noch in den Kinderschuhen. „Für den Computer ist ein Text kein Wissen, sondern nur Worte, die aneinandergereiht werden“, umreißt der Forscher das Grundproblem. „In der Sprache machen oft einzelne Wörter große Unterschiede. Bei Hate Speech, Satire oder Sarkasmus geht man in extrem komplexe subtile Subkontexte hinein.“ Ein Abgleich von Fakten mit Datenbanken wie z. B. Wikpedia funktioniere daher maximal bei einer sehr formellen Sprache. Mit Hilfe von KI können Wörter dabei immer besser in einen Kontext gesetzt werden. „Die große Herausforderung ist, wie man verschiedene Datenbestände referenziert“, so Schindler.

Wie wirken Fake News?

Daher verfolgen die Forscherinnen und Forscher auch andere Ansätze. Vielversprechend ist die Analyse, wie Nutzer auf Nachrichten in Sozialen Netzwerken reagieren („Stance Detection“). Wird eine Meldung positiv aufgenommen? Entbrennt eine Kontroverse? Gibt es ausgeprägte Echo-Kammern? Und grundsätzlicher: Wie verbreiten sich Fake News in Sozialen Netzen? „Wenn man all das zusammenfügt – die Verbreitung, die Reaktionen der Menschen und die inhaltliche Analyse – kommt man bereits zu sehr guten Ergebnissen“, berichtet Schindler. In Experimenten am AIT konnten damit Fake News in Artikeln zu rund 85 Prozent korrekt klassifiziert werden.

Allerdings reiche es nicht aus, eine Nachricht als Ganzes als richtig oder falsch einzustufen – man brauche detailliertere Informationen, welche Teile eines Textes falsch sind, erläutert Ross King. Dabei wenden die Expertinnen und Experten am AIT Methoden der sogenannten „explainable AI“ an. Dabei wird analysiert, wie eine KI zu der Entscheidung „wahr“ oder „fake“ kommt – also welche Faktoren zu einer solchen Klassifikatoren geführt haben. In einer Versuchsreihe am AIT wurde beispielsweise untersucht, welche Schlagworte zur Einstufung eines Textes als diskriminierend geführt haben. „Es war schön zu sehen, dass sich die Worte, auf die Machine Learning anspricht, mit Schlagworten aus einer linguistischen Analyse überlappen“, berichtet Alexander Schindler.

Eine „Nährwerttabelle“ für Texte

Basierend auf solchen Erkenntnissen soll ein System konstruiert werden, das in Texten kritische Wörter kennzeichnet und zudem Internet-Links vorschlägt, wo man verdächtige Passagen gegenchecken kann. Schindler schwebt so etwas wie eine „Nährwerttabelle“ zu einem Artikel vor, der etwas über den Wahrheitsgehalt und den Polarisierungsgrad aussagt und darüber Auskunft gibt, ob ein Artikel faktenbasiert oder eher emotionalisierend ist.

„Wir brauchen solche hilfreichen Werkzeuge“, resümiert Ross King. Diese würden auch zu einem höheren Bewusstsein der Nutzer beitragen, bei Inhalten im Internet skeptischer zu sein und sich deren Herkunft genauer anzusehen („Digital Litteracy“).

Gesamtheitliche Interpretation

In der Forschung geht man nun noch einen Schritt weiter: Um „Fake News“ noch treffsicherer zu erkennen, will man die Analyseergebnisse aus den unterschiedlichen Bereichen – Bild, Video, Audio, Texte – miteinander kombinieren, um auf diese Weise eine gesamtheitliche Interpretation zu ermöglichen. „Das Schwierige dabei ist, dass man die unterschiedlichen Modalitäten nicht so einfach zusammenfassen kann“, erläutert Alexander Schindler. Helfen soll dabei eine auf KI basierte Fusionslogik.

Ein derartiges System, das klassische und KI-gesteuerte Ansätze kombiniert, wird derzeit in einem Projekt im Rahmen des österreichischen Sicherheitsforschungsprogramm KIRAS entwickelt. Am Ende dieses auf zwei Jahre angelegten Forschungsvorhabens soll ein auf KI basierendes Fake-News-Detektionssystem stehen, das auf die jeweiligen Endanwender abgestimmt ist und im täglichen Arbeitsumfeld einsetzbar ist. Dies soll zum einen den Nutzern eine erste Beurteilung der Glaubwürdigkeit von Inhalten ermöglichen und zum anderen der öffentlichen Hand Möglichkeiten zum raschen Handeln geben.

Weiterführender Link

IDSF VIENNA 2020

Das Thema Fake News spielt auch beim „International Digital Security Forum“ (IDSF) eine zentrale Rolle, das heuer am 2. und 3. Dezember als hybride Konferenz in Wien stattfindet. Das Motto dieser vom AIT Austrian Institute of Technology und der Wirtschaftskammer Österreich (WKO) organisierten Veranstaltung lautet „Security in times of pandemics and major global events“. Geplant sind Sessions u. a. zu den Themen Grenzmanagement, Cyber Crime, Situation Awareness, Fake News oder Digital Resilience. Das Ziel der IDSF ist es, die Kooperation zwischen Forschung, privatem und öffentlichem Sektor für die Entwicklung und Anwendung von Technologien für gesellschaftlich erwünschte Entwicklungen zu stärken.